robots.txt – служебный файл, который находится в корневом каталоге сайта и содержит набор директив, позволяющих управлять индексацией сайта. Когда краулер приходин на хостинг , файл robots.txt является первым документом обращаясь к нему.

В robots.txt содержатся инструкции поисковым роботам какие URL адресов на вашем сайте им разрешено обрабатывать. С помощью него можно снизить нагрузку на сайт ограничив количество запросов на сканирование. Файл robots.txt не предназначен запрещать показ ваших материалов в результатах поиска Google, если хотите скрыть страницы сайта сделайте их по паролю или добавьте директиву noindex.

Robots.txt используется для исключения дубликатов, служебных страниц, удаленных страниц, и не нужных страниц из индекса поисковых систем. Через robots.txt можно подключить адрес карты сайта localhost/sitemap.xml . Рекомендации запретить при помощи robots.txt сканировать файлы : скрипты, стили, картинки если они не влияют на оформление страницы и не нужно что бы робот их посещал.

Если доступ к странице запрещен в файле robots.txt она все равно может быть проиндексирована по ссылкам с других сайтов. Google не будет напрямую сканировать и индексировать контент, который заблокирован в файле robots.txt. Однако если на URL ссылаются другие сайты, то он может быть найден и добавлен в результатах поиска ( с текстом ссылки на которую она ведет ).

Пример простого файла robots.txt с двумя правила:

User-agent: Googlebot

Disallow: /nogooglebot/

User-agent: *

Allow: /

Sitemap: https://webdomic.com/sitemap.xml

Пояснение:

- Агенту пользователя с названием Googlebot запрещено сканировать любые URL, начинающие с Sitemap: https://webdomic.com/nogooglebot/

- Любым агентам разрешено сканировать сайт целиком.

- Файл Sitemap карты сайта находится по адресу https://webdomic.com/sitemap.xml

Файл robots.txt должен быть единственным и располагаться в корне сайта.

Для файлов robots.txt можно использовать URL с субдоменами, число директив не должно превышать 1024. Символ # предназначен для описания комментариев все что после символа и до первого перевода строки не учитывается.

Файл robots.txt имеет формат plain text в кодировке UTF-8 и называться robots.txt . Поле User-agent – директива определяет робота поисковых систем к которому относится правило индексации сайта.

Внутри директивы User-agent используют следующие правила:

В каждом правиле должна быть одна директива Disallow: (Запретить) или Allow: (Разрешить) .

Disallow: Указывает на каталог или страницу в корневом домене, которые нельзя сканировать поисковым роботом. Если это каталог путь к нему заканчивается слешем.

Allow: Директива указывает на каталог или страницу в корневом домене, которые нужно сканировать поисковым роботам.

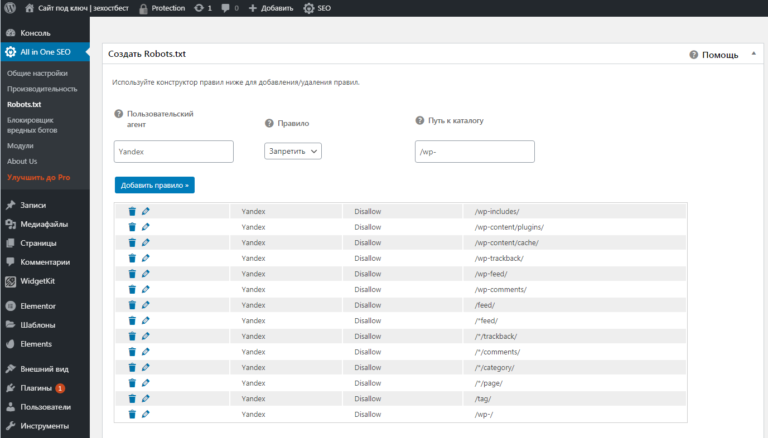

Пример моего файла robots.txt для Google и Yandex:

User-agent: Googlebot

Allow: /wp-admin/admin-ajax.php

Allow: /*/uploads/

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-*.svg

Disallow: /wp-admin/

Disallow: /cgi-bin/

Disallow: /?/

Disallow: /wp-/

Disallow: /*?s=/

Disallow: /*&s=/

Disallow: /*?attachment_id=/

Disallow: /*/trackback/

Disallow: /*/feed/

Disallow: /*/rss/

Disallow: /*/embed/

Disallow: /author/

Disallow: /wp-json/

Disallow: /*/xmlrpc.php

Disallow: /*/page/

Disallow: /search/

Disallow: /*utm*=/

Disallow: /*openstat=/

User-agent: Yandex

Allow: /wp-admin/admin-ajax.php

Allow: /*/uploads/

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-*.svg

Disallow: /wp-admin/

Disallow: /cgi-bin/

Disallow: /?/

Disallow: /wp-/

Disallow: /*?s=/

Disallow: /*&s=/

Disallow: /*?attachment_id=/

Disallow: /*/trackback/

Disallow: /*/feed/

Disallow: /*/rss/

Disallow: /*/embed/

Disallow: /author/

Disallow: /wp-json/

Disallow: /*/xmlrpc.php

Disallow: /*/page/

Disallow: /search/

Disallow: /*utm*=/

Disallow: /*openstat=/

Sitemap: https://webdomic.com/sitemap.xml